BASE_II

-

Upload

nilton-meneses-flores -

Category

Documents

-

view

3 -

download

0

Transcript of BASE_II

UNIVERSIDAD NACIONAL DE INGENIERIA

Sql server integracion service (SSIS)

INTEGRANTES:JACOBI RIOS, JHONY

OSORIO GARCIA, DANIEL

PAREDES MOSQUERA, HANS

INDICE

I. INTRODUCCION.....................................................................................................................2

II. SQL SERVER INTEGRATION SERVICES (SSIS).............................................................3

III. Tareas de Integration Services..........................................................................................3

a. Tarea Ejecutar DDL.............................................................................................................4

b. Tarea Procesamiento de Analysis Services....................................................................4

c. Tarea Consulta de minería de datos.................................................................................4

IV. Minería de datos y el Aporte de SSIS...............................................................................4

1. Definir el problema..............................................................................................................6

2. Preparar los datos (SSIS)...................................................................................................7

3. Explorar los datos................................................................................................................8

4. Generar modelos.................................................................................................................9

5. Explorar y validar los modelos.........................................................................................10

6. Implementar y actualizar los modelos (SSIS)................................................................11

V. ARQUITECTURA DE SSIS..................................................................................................13

VI. APLICACIONES................................................................................................................15

VII. IMPORTANCIA..................................................................................................................16

Desafíos de la integración de datos................................................................................16

Desafíos tecnológicos.......................................................................................................16

Desafíos de organización................................................................................................18

Desafíos económicos........................................................................................................18

INTEGRANTES:JACOBI RIOS, JHONY

OSORIO GARCIA, DANIEL

PAREDES MOSQUERA, HANS

I. INTRODUCCION

Algo peor que no tener información disponible es tener mucha información y no saber qué hacer con ella. La Inteligencia de Negocios o Business Intelligence (BI) es la solución a ese problema, pues por medio de dicha información puede generar escenarios, pronósticos y reportes que apoyen a la toma de decisiones, lo que se traduce en una ventaja competitiva. La clave para BI es la información y uno de sus mayores beneficios es la posibilidad de utilizarla en la toma de decisiones. En la actualidad hay una gran variedad de software de BI con aplicaciones similares que pueden ser utilizados en las diferentes áreas de la empresa, tales como, ventas, marketing, finanzas, etc. Son muchas las empresas que se han beneficiado por la implementación de una sistema de BI, además se pronostica que con el tiempo se convertirá en una necesidad de toda empresa.Analysis Services trae una plataforma business intelligence de gran alcance para SQL Server, permitiendo poner en ejecución OLAP data warehouses y usar técnicas de data mining para analizar datos de negocio y tomar decisiones apropiadas.

II. SQL SERVER INTEGRATION SERVICES (SSIS)

Microsoft IntegrationServices es una plataforma para la creación de soluciones empresariales de transformaciones de datos e integración de datos. Integration Services sirve para resolver complejos problemas empresariales mediante la copia o descarga de archivos, el envío de mensajes de correo electrónico como respuesta a eventos, la actualización de almacenamientos de datos, la limpieza y minería de datos, y la administración de objetos y datos de SQL Server.Los paquetes pueden funcionar en solitario o junto con otros paquetes para hacer frente a las complejas necesidades de la empresa.Integration Services puede extraer y transformar datos de diversos orígenes como archivos de datos XML, archivos planos y orígenes de datos relacionales y, después, cargar los datos en uno o varios destinos.

Integration Services contiene un variado conjunto de tareas y transformaciones integradas, herramientas para la creación de paquetes y el servicio Integration Services para ejecutar y administrar los paquetes. Las herramientas gráficas de Integration Services se pueden usar para crear soluciones sin escribir una sola línea de código. También se puede programar el amplio modelo de objetos de Integration Services para crear paquetes mediante programación y codificar tareas personalizadas y otros objetos de paquete.

Microsoft SQL Server IntegrationServices permite automatizar la ejecución de scripts DDL, tareas de procesamiento de cubos y modelos de minería de datos, y tareas de consulta de minería de datos. IntegrationServices puede considerarse como una colección de tareas de flujo de control y de mantenimiento, que pueden vincularse para formar trabajos de procesamiento de datos secuenciales y paralelos.IntegrationServices se ha diseñado para realizar operaciones de limpieza de datos durante las tareas de procesamiento y para reunir datos procedentes de diferentes orígenes de datos. Cuando se trabaja con cubos y modelos de minería de datos, IntegrationServices puede transformar datos no numéricos en datos numéricos y puede garantizar que esos valores de datos se encuentran dentro de los límites esperados, creando así datos limpios desde los cuales llenar dimensiones y tablas de hechos.

III. Tareas de IntegrationServices

Existen dos elementos principales en cualquier tarea o trabajo de IntegrationServices: elementos de flujo de control y elementos de flujo de datos. Los elementos de flujo de control definen el orden lógico de la progresión del trabajo aplicando restricciones de precedencia. Los elementos de flujo de datos se refieren a la conectividad entre la salida de un componente y la entrada del componente siguiente y a cualquier transformación de datos que puede llevarse a cabo en los datos entre ambas acciones. En cuanto a la decisión sobre el destino de los datos, las restricciones de precedencia contienen lógica que especifica qué componente recibe la salida. Las tareas de IntegrationServices más relevantes para Microsoft SQL Server AnalysisServices incluyen las tareas Ejecutar DDL, Procesamiento de AnalysisServices y Consulta de minería de datos. Para cada una de

estas tareas, se puede utilizar la tarea Enviar correo para enviar al administrador un mensaje de correo electrónico que contenga los resultados de la tarea.

a. Tarea Ejecutar DDL(data definition language or data description language (DDL) is a syntax similar to a computer programming language)

La tarea Ejecutar DDL de IntegrationServices permite enviar directamente scripts DDL al servidor de AnalysisServices y ejecutarlos de forma automática. Esto permite que el administrador de AnalysisServices realice operaciones de copia de seguridad, de restauración o de sincronización desde un paquete de IntegrationServices. Un paquete se compone de los elementos de flujo de control y de flujo de datos descritos anteriormente. Todos se deben runregularly, al igual que otras instrucciones DDL que pueden agregarse a las tareas. Debido a que las tareas aquí tratadas se ejecutan frecuentemente en horario nocturno, resulta especialmente útil disponer de paquetes que puede ejecutarse con facilidad desde cualquier aplicación de programación. Puede programar que un paquete se ejecute en cualquier momento usando el Agente IntegrationServices.

b. T area Procesamiento de AnalysisServices

La tarea Procesamiento de AnalysisServices de IntegrationServices permite llenar automáticamente los cubos con nueva información cuando se realizan actualizaciones periódicas de la base de datos relacional de origen. Puede realizar el procesamiento en el nivel de dimensión, de cubo o de partición mediante la tarea Procesamiento de AnalysisServices. El propio procesamiento puede ser de tipo incremental o full; esta opción se selecciona basándose en los requisitos del trabajo. El procesamiento incremental agrega nuevos datos y lleva a cabo suficiente trabajo de cálculo para mantener actualizado el destino, en tanto que el procesamiento completo realiza una nueva carga y un nuevo cálculo completos de los datos existentes. El procesamiento completo requiere más tiempo, pero es más absoluto.

c. Tarea Consulta de minería de datos

La tarea Consulta de minería de datos de IntegrationServices permite extraer y almacenar información de los modelos de minería de datos. Por lo general, la información se almacena en una base de datos relacional y puede utilizarse, por ejemplo, para aislar una lista de clientes potenciales para una campaña de correo directo. La minería de datos puede identificar el valor de un cliente y la probabilidad de que ese cliente responda a una determinada acción de marketing. Puede utilizar la tarea Consulta de minería de datos para extraer y modificar datos en un formato de preferencia.

IV. Minería de datos y el Aporte de SSIS

La minería de datos es el proceso de detectar la información procesable de los conjuntos grandes de datos. Utiliza el análisis matemático para deducir los patrones y tendencias que existen en los datos. Normalmente, estos patrones no se pueden detectar mediante la exploración tradicional de los datos porque las relaciones son demasiado complejas o porque hay demasiado datos.

Estos patrones y tendencias se pueden recopilar y definir como un modelo de minería de datos. Los modelos de minería de datos se pueden aplicar a situaciones empresariales como las siguientes:

Predecir ventas Dirigir correo a clientes específicos Determinar los productos que se pueden vender juntos Buscar secuencias en el orden en que los clientes agregan productos a una cesta

de compra

La generación de un modelo de minería de datos forma parte de un proceso mayor que incluye desde la formulación de preguntas acerca de los datos y la creación de un modelo para responder dichas cuestiones, hasta la implementación del modelo en un entorno de trabajo. Este proceso se puede definir mediante los seis pasos básicos siguientes:

1. Definir el problema2. Preparar los datos3. Explorar los datos4. Generar modelos5. Explorar y validar los modelos6. Implementar y actualizar los modelos

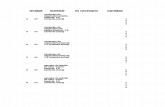

El siguiente diagrama describe las relaciones entre cada paso del proceso y las tecnologías de Microsoft SQL Server que se pueden utilizar para completar cada paso.

Aunque el proceso que se ilustra en el diagrama es circular, esto no significa que cada paso conduzca directamente al siguiente. La creación de un modelo de minería de datos es un proceso dinámico e iterativo. Una vez que ha explorado los datos, puede que descubra que resultan insuficientes para crear los modelos de minería de datos adecuados y que, por tanto, debe buscar más datos. O bien, puede generar varios modelos y descubrir entonces que no responden adecuadamente al problema planteado cuando los definió y que, por tanto, debe volver a definir el problema. Es posible que deba actualizar los modelos una vez implementados debido a que haya más datos disponibles.

Puede que haya que repetir cada paso del proceso muchas veces para crear un modelo adecuado.

SQL Server 2008 ofrece un entorno integrado para crear y trabajar con modelos de minería de datos denominado Business IntelligenceDevelopment Studio. Este entorno incluye algoritmos y herramientas de minería de datos que facilitan la generación de una solución completa para diversos proyectos..

Después de haber creado una solución de minería de datos, puede mantenerla y examinarla utilizando SQL Server Management Studio.

1. Definir el problema

El primer paso del proceso de minería de datos, como se resalta en el siguiente diagrama, consiste en definir claramente el problema empresarial y considerar formas de proporcionar una respuesta para el mismo.

Este paso incluye analizar los requisitos empresariales, definir el ámbito del problema, definir las métricas por las que se evaluará el modelo y definir los objetivos concretos del proyecto de minería de datos. Estas tareas se traducen en preguntas como las siguientes:

¿Qué está buscando? ¿Qué tipos de relaciones intenta buscar? ¿Refleja el problema que está intentando resolver las directivas o procesos de la

empresa? ¿Desea realizar predicciones a partir del modelo de minería de datos o solamente

buscar asociaciones y patrones interesantes? ¿Qué atributo del conjunto de datos desea intentar predecir? ¿Cómo se relacionan las columnas? En caso de que haya varias tablas, ¿cómo se

relacionan? ¿Cómo se distribuyen los datos? ¿Los datos son estacionales? ¿Los datos

representan con precisión los procesos de la empresa?

Para responder a estas preguntas, puede que deba dirigir un estudio de disponibilidad de datos para investigar las necesidades de los usuarios de la empresa con respecto a los datos disponibles. Si los datos no abarcan las necesidades de los usuarios, podría tener que volver a definir el proyecto.

También debe considerar las maneras en las que los resultados del modelo se pueden incorporar en los indicadores de rendimiento clave (KPI) que se utilizan para medir el progreso comercial.

2. Preparar los datos (SSIS)

El segundo paso del proceso de minería de datos, como se indica en el siguiente diagrama, consiste en consolidar y limpiar los datos identificados en el paso Definir el problema.

Los datos pueden estar dispersos en la empresa y almacenados en formatos distintos; también pueden contener incoherencias como entradas que faltan o incorrectas. Por ejemplo, los datos pueden mostrar que un cliente adquirió un producto incluso antes que se ofreciera en el mercado o que el cliente compra regularmente en una tienda situada a 2.000 kilómetros de su casa.

La limpieza de datos no solamente implica quitar los datos no válidos, sino también buscar las correlaciones ocultas en los datos, identificar los orígenes de datos que son más precisos y determinar qué columnas son las más adecuadas para usarse en el análisis. Por ejemplo, ¿debería utilizar la fecha de envío o la fecha de pedido? ¿Qué influye más en las ventas: la cantidad, el precio total o un precio con descuento? Los datos incompletos, los datos equivocados y las entradas que parecen independientes, pero que de hecho están estrechamente correlacionadas pueden influir en los resultados del modelo de maneras que no espera. Por consiguiente, antes de empezar a generar los modelos de minería de datos, debería identificar estos problemas y determinar cómo los corregirá.

Normalmente se trabaja con un conjunto de datos muy grande y no se puede comprobar cada transacción. Por consiguiente, tiene que utilizar alguna forma de automatización, como en IntegrationServices, para explorar los datos y buscar las incoherencias. Microsoft IntegrationServices contiene todas las herramientas necesarias para completar este paso, incluidas las transformaciones para automatizar la limpieza y consolidación de los datos.

Es importante tener en cuenta que los datos que utiliza para la minería de datos no necesitan almacenarse en un cubo de Procesamiento analítico en línea (OLAP), ni siquiera en una base de datos relacional, aunque puede utilizarlos ambos como orígenes de datos. Puede realizar minería de datos mediante cualquier origen de datos definido como origen de datos de AnalysisServices. Por ejemplo, archivos de texto, libros de Excel o datos de otros proveedores externos

3. Explorar los datos

El tercer paso del proceso de minería de datos, como se resalta en el siguiente diagrama, consiste en explorar los datos preparados.

Debe conocer los datos para tomar las decisiones adecuadas al crear los modelos de minería de datos. Entre las técnicas de exploración se incluyen calcular los valores mínimos y máximos, calcular la media y las desviaciones estándar, y examinar la distribución de los datos. Por ejemplo, al revisar el máximo, el mínimo y los valores de la media se podría determinar que los datos no son representativos de los clientes o procesos de negocio, y que por consiguiente debe obtener más datos equilibrados o revisar las suposiciones que son la base de sus expectativas. Las desviaciones estándar y otros valores de distribución pueden proporcionar información útil sobre la estabilidad y exactitud de los resultados. Una desviación estándar grande puede indicar que agregar más datos podría ayudarle a mejorar el modelo. Los datos que se desvían mucho de una distribución estándar se podrían sesgar o podrían representar una imagen precisa de un problema de la vida real, pero dificultar el ajustar un modelo a los datos.

Al explorar los datos para conocer el problema empresarial, puede decidir si el conjunto de datos contiene datos defectuosos y, a continuación, puede inventar una estrategia para corregir los problemas u obtener una descripción más profunda de los comportamientos que son típicos de su negocio.

El diseñador de vistas del origen de datos de BI Development Studio contiene varias herramientas que se pueden utilizar para explorar los datos.

Además, al crear un modelo, AnalysisServices crea automáticamente resúmenes estadísticos de los datos contenidos en él, que puede consultar para utilizarlos en informes o para continuar el análisis.

4. Generar modelos

El cuarto paso del proceso de minería de datos, como se resalta en el siguiente diagrama, consiste en generar el modelo o modelos de minería de datos. Utilizará los conocimientos adquiridos en el pasoExplorar los datos para definir y crear los modelos.

Defina qué datos desea que se utilicen creando una estructura de minería de datos. La estructura de minería de datos define el origen de datos, pero no contiene ningún dato hasta que lo procesa. Al procesar la estructura de minería de datos, AnalysisServices genera los agregados y otra información estadística que se puede utilizar para el análisis. Cualquier modelo de minería de datos que esté basado en la estructura puede utilizar esta información.

Antes de que se procese el modelo, un modelo de minería de datos simplemente es un contenedor que especifica las columnas que se usan para la entrada, el atributo que está prediciendo y parámetros que indican al algoritmo cómo procesar los datos. El proceso de un modelo también se denomina entrenamiento. El entrenamiento hace referencia al proceso de aplicar un algoritmo matemático concreto a los datos de la estructura para extraer patrones. Los patrones que encuentre en el proceso de entrenamiento dependerán de la selección de los datos de entrenamiento, el algoritmo que elija y cómo se haya configurado el algoritmo. SQL Server 2008 contiene muchos algoritmos diferentes. Cada uno está preparado para un tipo diferente de tarea y crea un tipo distinto de modelo.

También puede utilizar los parámetros para ajustar cada algoritmo y puede aplicar filtros a los datos de entrenamiento para utilizar un subconjunto de los datos, creando resultados diferentes. Después de pasar los datos a través del modelo, el objeto de modelo de minería de datos contiene los resúmenes y modelos que se pueden consultar o utilizar para la predicción.

Puede definir un modelo nuevo mediante el Asistente para minería de datos de BI Development Studio o con el lenguaje DMX (Extensiones de minería de datos).

Es importante recordar que siempre que los datos cambian, debe actualizar la estructura y el modelo de minería de datos. Al actualizar una estructura de minería de datos

volviéndola a procesar, AnalysisServices recupera los datos del origen, incluido cualquier dato nuevo si el origen se actualiza dinámicamente, y vuelve a rellenar la estructura de minería de datos. Si tiene modelos que están basados en la estructura, puede elegir actualizar estos, lo que significa que se vuelven a entrenar con los nuevos datos, o puede dejar los modelos tal cual.

5. Explorar y validar los modelos

El quinto paso del proceso de minería de datos, como se resalta en el siguiente diagrama, consiste en explorar los modelos de minería de datos que ha generado y comprobar su eficacia.

Antes de implementar un modelo en un entorno de producción, es aconsejable probar si funciona correctamente. Además, al generar un modelo, normalmente se crean varios con configuraciones diferentes y se prueban todos para ver cuál ofrece los resultados mejores para su problema y sus datos.

AnalysisServices proporciona herramientas que ayudan a separar los datos en conjuntos de datos de entrenamiento y pruebas, para que pueda evaluar con precisión el rendimiento de todos los modelos en los mismos datos. El conjunto de datos de entrenamiento se utiliza para generar el modelo y el conjunto de datos de prueba para comprobar la precisión del modelo mediante la creación de consultas de predicción. En SQL Server 2008 AnalysisServices, este particionamiento se puede hacer automáticamente mientras se genera el modelo de minería de datos. Puede explorar las tendencias y patrones que los algoritmos detectan mediante los visores del diseñador de minería de datos de BI Development Studio. También puede comprobar si los modelos crean predicciones correctamente mediante herramientas del diseñador como el gráfico de elevación y la matriz de clasificación. Para comprobar si el modelo es específico de sus datos o se puede utilizar para realizar inferencias en la población general, puede

utilizar la técnica estadística denominada validación cruzada para crear automáticamente subconjuntos de los datos y probar el modelo con cada uno.

Si ninguno de los modelos que ha creado en el paso Generar modelos funciona correctamente, puede que deba volver a un paso anterior del proceso y volver a definir el problema o volver a investigar los datos del conjunto de datos original.

6. Implementar y actualizar los modelos (SSIS)

El último paso del proceso de minería de datos, como se resalta en el siguiente diagrama, consiste en implementar los modelos que funcionan mejor en un entorno de producción.

Una vez que los modelos de minería de datos se encuentran en el entorno de producción, puede llevar acabo diferentes tareas, dependiendo de sus necesidades. Las siguientes son algunas de las tareas que puede realizar:

Utilizar los modelos para crear predicciones que pueda utilizar para tomar decisiones empresariales. SQL Server ofrece el lenguaje DMX, que puede utilizar para crear consultas de predicción, y el Generador de consultas de predicción, que le ayuda a generar las consultas.

Crear consultas de contenido para recuperar estadísticas, reglas o fórmulas del modelo.

Incrustar la funcionalidad de minería de datos directamente en una aplicación. Puede incluir Objetos de administración de análisis (AMO), que contiene un conjunto de objetos que la aplicación pueda utilizar para crear, cambiar, procesar y eliminar estructuras y modelos de minería de datos. También puede enviar mensajes XML forAnalysis (XMLA) directamente a una instancia de AnalysisServices.

Utilizar IntegrationServices para crear un paquete en el que se utilice un modelo de minería de datos para dividir de forma inteligente los datos entrantes en varias tablas. Por ejemplo, si una base de datos se actualiza continuamente con clientes potenciales, puede utilizar un modelo de minería de datos junto con IntegrationServices para dividir los datos entrantes en clientes que probablemente compren un producto y clientes que probablemente no compren un producto.

Crear un informe que permita a los usuarios realizar consultas directamente en un modelo de minería de datos existente (ReportingServices en Business IntelligenceDevelopment Studio (SSRS) )

Actualizar los modelos después de la revisión y análisis. Cualquier actualización requiere que vuelve a procesar los modelos.

Actualizar dinámicamente los modelos, cuando entren más datos en la organización, y realizar modificaciones constantes para mejorar la efectividad de la solución debería ser parte de la estrategia de implementación.

V. ARQUITECTURA DE SSIS

Como se muestra en el diagrama siguiente, Microsoft SQL Server IntegrationServices incluye diversos componentes.

De los componentes mostrados en el diagrama anterior, los siguientes son importantes para utilizar IntegrationServices correctamente:

Diseñador SSIS

El Diseñador SSIS es una herramienta gráfica que se puede usar para crear y mantener paquetes IntegrationServices. El Diseñador SSIS está disponible en Business IntelligenceDevelopment Studio como parte de un proyecto de IntegrationServices.

Motor en tiempo de ejecución

El tiempo de ejecución de IntegrationServices guarda el diseño de paquetes, ejecuta paquetes y admite registros, puntos de interrupción, configuración, conexiones y transacciones.

Tareas y otros ejecutables

Los ejecutables de tiempo de ejecución de IntegrationServices son el paquete, los contenedores, las tareas y los controladores de eventos que incluye IntegrationServices. Los ejecutables de tiempo de ejecución también incluyen tareas personalizadas que el usuario puede desarrollar.

Motor de flujo de datos (también conocido como canalización) y componentes de flujo de datos

La tarea Flujo de datos encapsula el motor de flujo de datos. El motor de flujo de datos proporciona los búferes en memoria que mueven datos desde el origen hasta el destino y llama los orígenes que extraen datos de archivos y bases de datos relacionales. El motor de flujo de datos también administra las transformaciones que modifican datos y los destinos que cargan datos o los ponen a disposición de otros procesos. IntegrationServices Los componentes de flujo de datos son los orígenes, transformaciones y destinos que se utilizan diferentes tipos de elementos de flujo de datos: orígenes que extraen datos, transformaciones que IntegrationServices incluye. También puede incluir componentes personalizados en un flujo de datos.

API o modelo de objetos

El modelo de objetos de IntegrationServices incluye interfaces de programación de aplicaciones (API) administradas para crear componentes personalizados para su uso en paquetes, o aplicaciones personalizadas que crean, cargan, ejecutan y administran paquetes. El programador puede escribir aplicaciones personalizadas o tareas y transformaciones personalizadas utilizando cualquier lenguaje que cumpla con CommonLanguageRuntime (CLR).

Servicio IntegrationServices

El servicio IntegrationServices permite usar SQL Server Management Studio para supervisar paquetes IntegrationServices en ejecución y para administrar el almacenamiento de los paquetes.

Asistente para importación y exportación de SQL Server

El Asistente para importación y exportación de SQL Server puede copiar datos entre orígenes de datos para los que esté disponible un proveedor de datos de .NET Framework administrado o un proveedor OLE DB nativo. El Asistente ofrece también el método más simple para crear un paquete IntegrationServices que copia datos de un origen en un destino.

Otras herramientas, asistentes y utilidades de símbolo del sistema

IntegrationServices incluye herramientas, asistentes y utilidades de símbolo del sistema adicionales para ejecutar y administrar paquetes de IntegrationServices.

VI. APLICACIONES

Proyectos de Integration Services

Describe los proyectos que actúan como contenedores para los paquetes Integration Services en tiempo de diseño.

Paquetes de Integration Services

Describe los paquetes.

Elementos de flujo de control

Describe los contenedores, tareas y restricciones de prioridad.

Elementos de flujo de datos

Describe los orígenes, transformaciones, destinos y rutas.

Conexiones de Integration Services

Describe los administradores de conexión.

Variables de Integration Services

Describe las variables definidas por el usuario y variables del sistema que proporciona Integration Services.

Controladores de eventos de Integration Services

Describe los eventos de tiempo de ejecución y los controladores de eventos que puede generar para los eventos.

Proveedores de registro de Integration Services

Describe los proveedores de registro que incluye IntegrationServices.

VII. IMPORTANCIALa capacidad de transformar datos corporativos en información con sentido y que se pueda procesar es la ventaja competititva más importante del mundo de los negocios actual. Controlar la explosión de datos para entender mejor el pasado y prepararse para el futuro se ha convertido en uno de los mayores desafíos de los departamentos de tecnologías de la información de las organizaciones internacionales Hay tres amplias categorías de temas relacionados con la integración de datos:

• Desafíos tecnológicos

• Problemas de organización

• Desafíos económicos

Desafíos de la integración de datosEn un nivel, el problema de la integración de datos en nuestro escenario real es extraordinariamente simple. Obtener datos de distintos orígenes, limpiar y transformar los datos, y cargarlos en almacenes que permitan su análisis y la creación de informes. Desafortunadamente, en un almacén de datos o en un proyecto de inteligencia empresarial típicos, las empresas emplean del 60 al 80% de los recursos disponibles en la etapa de integración de datos. ¿Qué problema plantea esto?

Desafíos tecnológicosLos desafíos tecnológicos comienzan con los sistemas de origen. Pasamos de recopilar datos sobre las transacciones (en las que los clientes se comprometen a obtener, comprar o adquirir algo) a recopilar datos sobre transacciones preliminares (en las que se realiza un seguimiento de las intenciones de los clientes mediante mecanismos como clics en Web o RFID). Los datos ahora no sólo se adquieren mediante los recursos y formatos tradicionales, como bases de datos y archivos de texto, sino que cada vez más están disponibles en una variedad de formatos distintos (como archivos de propietario, documentos de Microsoft Office y archivos basados en XML) y de orígenes basados en Internet, como servicios Web y secuencias de RSS (Really Simple Syndication). Los desafíos más pertinentes son:

• Diversos orígenes con formatos diferentes.

• Datos estructurados, semiestructurados y sin estructura.

• Suministros de datos de sistemas de origen que llegan en distintos momentos.

• Grandes volúmenes de datos.

En un mundo ideal, aunque logremos tener todos los datos que necesitamos en un lugar, comienzan a surgir nuevos desafíos, incluso:

• Calidad de los datos.

• Comprender los diferentes formatos de los datos.

• Transformar los datos en un formato que tenga sentido para los analistas empresariales.

Supongamos que, como por arte de magia, podemos obtener todos los datos necesarios y que podemos limpiarlos, transformarlos y asignarles un formato útil. Todavía queda otro cambio respecto del movimiento y la integración de datos tradicionales. El cambio consiste en pasar de procesos por lotes fijos y largos a procesos a petición fluidos y más cortos. Los procesos por lotes, por lo general, se

llevan a cabo durante “tiempos de inactividad”, cuando los usuarios no imponen fuertes exigencias al sistema. Esto suele suceder por la noche, en una ventana predefinida de lotes de 6 a 8 horas, cuando, por lo general, no hay nadie en la oficina. Debido a la creciente globalización de las empresas de todos los tipos y tamaños, esto ya no es así. Hay muy poco tiempo de inactividad (si es que hay), y siempre hay alguien en la oficina en algún lugar del mundo. El sol ya no se pone en la empresa global.Como resultado tenemos:

• Cada vez más presión para cargar los datos de la forma más rápida posible.

• La necesidad de cargar diversos destinos al mismo tiempo.

• Diversos destinos.

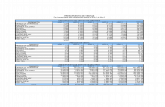

No sólo tenemos que hacer todo esto, sino que debemos hacerlo lo más rápido posible. En casos extremos, como el de las empresas en línea, los datos deben integrarse continuamente. No hay ventanas de lotes reales y las latencias no pueden durar más que minutos. En muchos de estos escenarios, el proceso de toma de decisiones se automatiza con un software que se ejecuta continuamente.La escalabilidad y el rendimiento son cada vez más importantes a medida que nos enfrentamos con necesidades empresariales que no admiten tiempos de inactividad.Sin la tecnología adecuada, los sistemas requieren almacenamiento provisional en casi todos los pasos del proceso de almacenamiento e integración. A medida que en el proceso ETL (extracción, transformación y carga) se deben incluir diferentes orígenes de datos (especialmente los que no son estándar) y sobre los datos se deben realizar operaciones de mayor complejidad (como la minería de datos y texto), aumenta la necesidad de almacenar de forma provisional los datos. Como se muestra en la figura 1, con un mayor almacenamiento provisional, también aumenta el tiempo necesario para “cerrar el bucle” (es decir, analizar y adoptar medidas para los nuevos datos). Estas arquitecturas ETL tradicionales (en contraposición a los procesos ETL con valor agregado que se desarrollan antes de la carga) imponen serias restricciones sobre la capacidad de respuesta de los sistemas frente a las nuevas necesidades empresariales.

Figura 1

Por último, la pregunta sobre cómo se adapta la integración de datos a la arquitectura de integración general de la organización es cada vez más importante en un momento en que, tanto la tecnología transaccional de integración de las aplicaciones en tiempo real, como el mundo de la tecnología de integración de datos en gran volumen y por lotes son necesarios para resolver los problemas empresariales.

Desafíos de organizaciónHay dos grandes problemas respecto de la integración de datos en una gran organización: la “energía” y la “zona de comodidad”.Desafío de la energía: Los datos son energía y, en general, es muy difícil lograr que la gente considere los datos un activo compartido valioso de la empresa. Para que la integración de los datos de la empresa se realice correctamente, todos los responsables de los diversos orígenes de datos tienen que aceptar sin condicionamientos el propósito y la dirección del proyecto. La falta de cooperación entre las partes pertinentes es una de las principales razones del fracaso de los proyectos de integración de datos. El patrocinio ejecutivo, la creación de consenso y un fuerte equipo de integración de datos con varios participantes son algunos de los factores críticos necesarios para el éxito que pueden ayudar a resolver los problemas.Desafío de la zona de comodidad: Los problemas de integración de datos, cuando se analizan en el contexto de una necesidad aislada, se pueden resolver de varias maneras. Alrededor del 60% de la integración de datos se resuelve mediante la codificación manual. La tecnología que se utiliza para resolver problemas similares puede ir desde réplica, ETL, SQL hasta EAI. La gente siempre recurre a la tecnología que conoce. A pesar de que estos enfoques tienen capacidades que se superponen y que tal vez puedan hacer el trabajo en casos aislados, estas tecnologías se optimizan para resolver diferentes grupos de problemas. Cuando se intenta resolver el problema de la integración de datos de una empresa, la falta de una arquitectura sólida con opciones tecnológicas adecuadas puede terminar siendo la receta para el fracaso.

Desafíos económicosLos problemas de organización y de tecnología descritos anteriormente conspiran para hacer que la integración de datos sea la parte más costosa de cualquier almacén de datos o proyecto de inteligencia empresarial. Los factores principales que contribuyen al costo de la integración de datos son:

• La minería de datos en el formato necesario para la integración termina siendo un proceso lento y tortuoso, lleno de juegos de poder en la organización.

• La limpieza de los datos de diversos orígenes y su asignación a un formato coherente y con sentido es extraordinariamente difícil.

• En general, la funcionalidad o la extensibilidad que ofrecen las herramientas estándar de integración de datos no es suficiente para satisfacer los requisitos de transformación de datos del proyecto. Esto puede tener como resultado el gasto de grandes cantidades de dinero en costos de consultoría para desarrollar un código ETL especial para llevar a cabo el trabajo.

• Diferentes sectores de la organización se concentran en el problema de integración de datos en silos.

Cuando se necesita juntarlos, se incurre en gastos adicionales para adaptar estos esfuerzos a una arquitectura de integración de datos para toda la empresa.A medida que aumentan las necesidades de almacenamiento de datos y de inteligencia empresarial de la organización, resulta cada vez más difícil mantener una arquitectura de integración de datos defectuosa, y el costo total de propiedad se dispara.

BIBLIOGRAFIAhttp://www.icode.es/portfolio-item/implantacion-de-business-intelligence/

http://www.microsoft.com/latam/technet/productos/servers/sql/2005/intro2is.mspx

http://pyme.lavoztx.com/cul-es-la-diferencia-entre-microsoft-ssrs-ssis-y-ssas-5599.html

http://programwar.wordpress.com/2012/12/02/02-manual-ssis-creacion-de-un-paquete-basico/

http://www.solidq.com/sqj/es/JournalDocuments/2011-March-Issue/Integration-Services-pieza-fundamental-en-los-proyectos-de-BI-(parte-1-de-2).pdf

http://dwjunkie.wordpress.com/2011/06/07/a-data-warehouse-in-4-steps/

Otros

http://bustamanteg.files.wordpress.com/2010/04/01-construyendo-nuestro-primer-cubo1.pdf

http://www.dataprix.com/ebooks/ti/administracion-sql-server-integration-services-analysis-services